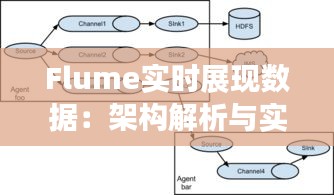

标题:Flume实时展现数据:架构解析与实战应用

引言

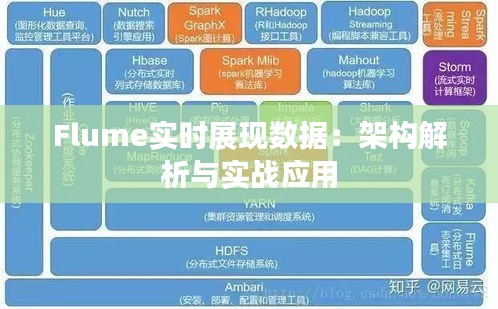

随着大数据时代的到来,实时数据处理成为了企业决策和业务运营的关键。Flume作为Apache基金会的一款开源分布式数据收集系统,能够高效地收集、聚合和移动大量日志数据。本文将深入解析Flume的架构设计,并探讨其在实时数据展现中的应用实践。

Flume架构解析

Flume的架构设计遵循了模块化的原则,主要由以下几个组件构成:

- Agent:Flume的基本工作单元,负责数据的收集、处理和传输。

- Source:数据源,负责从各种渠道收集数据,如文件、网络、命令行等。

- Sink:数据目的地,负责将数据存储到目标系统,如HDFS、HBase、Kafka等。

- Channel:数据缓冲区,负责在Source和Sink之间暂存数据,确保数据传输的可靠性。

- Sink Group:多个Sink的组合,用于实现数据的负载均衡。

Flume的工作流程如下:

- Source从数据源读取数据,并将数据放入Channel。

- Channel将数据缓存起来,等待Sink处理。

- Sink将Channel中的数据传输到目标系统。

Flume支持多种数据传输方式,包括内存、磁盘和JMS等,可以根据实际需求进行选择。

Flume实时数据展现应用

Flume在实时数据展现中的应用主要体现在以下几个方面:

1. 日志收集与展示

在互联网公司,日志数据是了解用户行为、优化系统性能的重要依据。Flume可以实时收集服务器日志、应用日志等,并通过Kafka、Elasticsearch等中间件进行数据存储和展示。

2. 实时监控

Flume可以与Prometheus、Grafana等监控工具结合,实现实时监控系统性能、网络流量等指标,为运维人员提供决策依据。

3. 数据分析

Flume可以与其他大数据处理框架(如Spark、Flink等)结合,实现实时数据分析,为业务决策提供支持。

实战案例:Flume与Kafka的集成

以下是一个Flume与Kafka集成的实战案例,实现从文件系统实时收集日志数据,并存储到Kafka中:

- 创建Flume Agent配置文件

flume-kafka.conf: - 启动Flume Agent:

- 在Kafka中查看数据:

# 定义Agent

agent.sources = source1

agent.sinks = sink1

agent.channels = channel1

# 定义Source

agent.sources.source1.type = exec

agent.sources.source1.command = tail -F /path/to/logfile.log

agent.sources.source1.channels = channel1

# 定义Channel

agent.channels.channel1.type = memory

agent.channels.channel1.capacity = 1000

agent.channels.channel1.transactionCapacity = 100

# 定义Sink

agent.sinks.sink1.type = kafka

agent.sinks.sink1.brokerList = localhost:9092

agent.sinks.sink1.topic = test

agent.sinks.sink1.channel = channel1

flume-ng agent -n flume-kafka -c /path/to/flume-kafka.conf -f /path/to/flume-kafka.conf -Dflume.root.logger=INFO,console

kafka-console-consumer --bootstrap-server localhost:9092 --topic test --from-beginning

通过以上步骤,我们可以实现从文件系统实时收集日志数据,并存储到Kafka中,为后续的数据处理和分析提供基础。

总结

Flume作为一款强大的实时数据处理工具,在日志收集、监控和数据分析等领域具有广泛的应用。通过本文的介绍,相信读者对Flume的架构设计和应用场景有了更深入的了解。在实际项目中,可以根据需求灵活配置Flume,实现高效的数据处理和展现。

转载请注明来自祥盛工程材料厂家,本文标题:《Flume实时展现数据:架构解析与实战应用》

鲁ICP备20033124号-2

鲁ICP备20033124号-2